Repasamos las peores críticas recibidas por 'The Lord of the Rings: Gollum'.

Características de los nuevos auriculares de Sony para PlayStation, que podrían suponer un antes y un después en tus partidas.

Sony anunció en el PlayStation Showcase el Project Q, su nueva consola portátil, pero no es cómo te imaginabas...

Todos los juegos anunciados por Sony en el PlayStation Showcase de 2023, tráilers incluidos.

'GTA 6', con un presupuesto de 1.000 millones, podría convertirse en el videojuego más caro de la historia doblando el anterior récord.

Te mostramos los 5 mejores altavoces inalámbricos con Bluetooth por menos de 100€ en relación calidad-precio para este verano.

Temu ha llegado a España ofreciendo 20 euros gratis a través de códigos y juegos en la app. Pero no es oro todo lo que reluce...

Mortal Kombat cumple 30 años: el juego que obligó la creación de la clasificación por edades.

PS5 Access, conocido anteriormente como Project Leonardo, es el primer mando de Sony accesible para personas con discapacidades motoras.

Google Pixel Fold, el primer plegable de Google y la competencia de los Galaxy Z Fold, se lanzará en junio, y se anunciará en el Google I/O de mayo.

POCO F5 y POCO F5 Pro: especificaciones y diferencias entre los dos nuevos flagships de POCO.

Repasamos los tráilers de juegos que nos emocionaron y conquistaron por su calidad, por su música, por su originalidad y se convirtieron en iconos de la industria.

Miyamoto ha hablado sobre el futuro de Super Mario en Switch y móviles, y deja caer que habrá pronto novedades para Nintendo.

Las vacunas de ARNm podrían ser la clave para acabar con el cáncer.

La NASA lanzó con éxito la nave Orión con destino la Luna en 2022 y dio comienzo al Programa Artemis, que enviará tripulación al suelo lunar en 2024.

El perro de Dogecoin se convierte en logo de Twitter en otra extraña decisión de Elon Musk.

Recordamos el histórico lanzamiento del Motorola DynaTAC 8000x hace 50 años y cómo Martin Cooper llamó a su rival con el propio móvil para darle la noticia.

"Es un riesgo para la sociedad y la humanidad": Elon Musk y cientos de expertos, contra la IA.

Apple, Amazon, Microsoft, Google y Samsung: estas cinco empresas son las más valiosas del mundo.

El E3 2023 ha sido cancelado por falta de interés, y ahora las dudas giran en torno a si volverá alguna vez.

Guía tutorial sobre cómo sacarle partido a las databases o bases de datos de Notion.

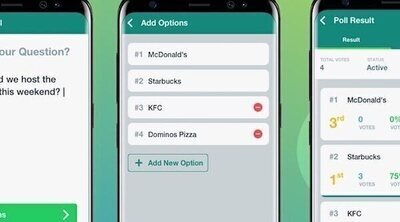

Las encuestas de Whatsapp, explicadas paso a paso en este tutorial.

Ni meterlo en arroz ni usar un secador: qué consejos debes seguir si tu móvil se te moja o se cae al agua.

La NBA es una liga particular, donde muchos más partidos se juegan fuera de casa que en terreno propio, lo que acaba afectando a las apuestas.

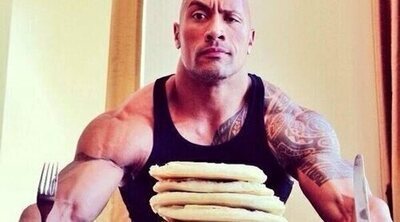

Explicamos los conceptos de ventana anabólica y catabolismo nocturno y cómo utilizarlos para ganar músculo.

El triple supuso toda una revolución en la NBA e indispensable para entender cómo ha evolucionado la competición.

La leche tiene más beneficios en los músculos de los que imaginas, y por eso es la bebida recomendada para el gimnasio.

La dieta Okinawa es una de las más famosas del mundo: avalada por la longevidad de sus habitantes, ayudan además a que tu cuerpo sea mucho mas sano y enérgico.

Un estudio de la UNSW demuestra que los cheat meals o cheat days pueden afectar seriamente a tu cerebro.

Descubre cómo elegir y usar una balaclava correctamente para máxima protección y confort en climas extremos.

Las adidas Predator Accuracy, Copa Pure y X Crazyfast se unen a Prada para crear las primeras botas de fútbol de lujo.

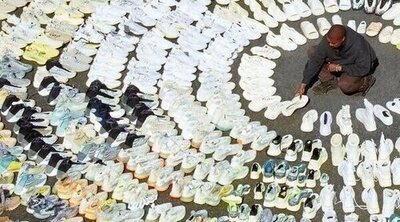

Adidas confirma que todo el stock de Yeezy saldrá finalmente a la venta, y planea donar parte de las ganancias.